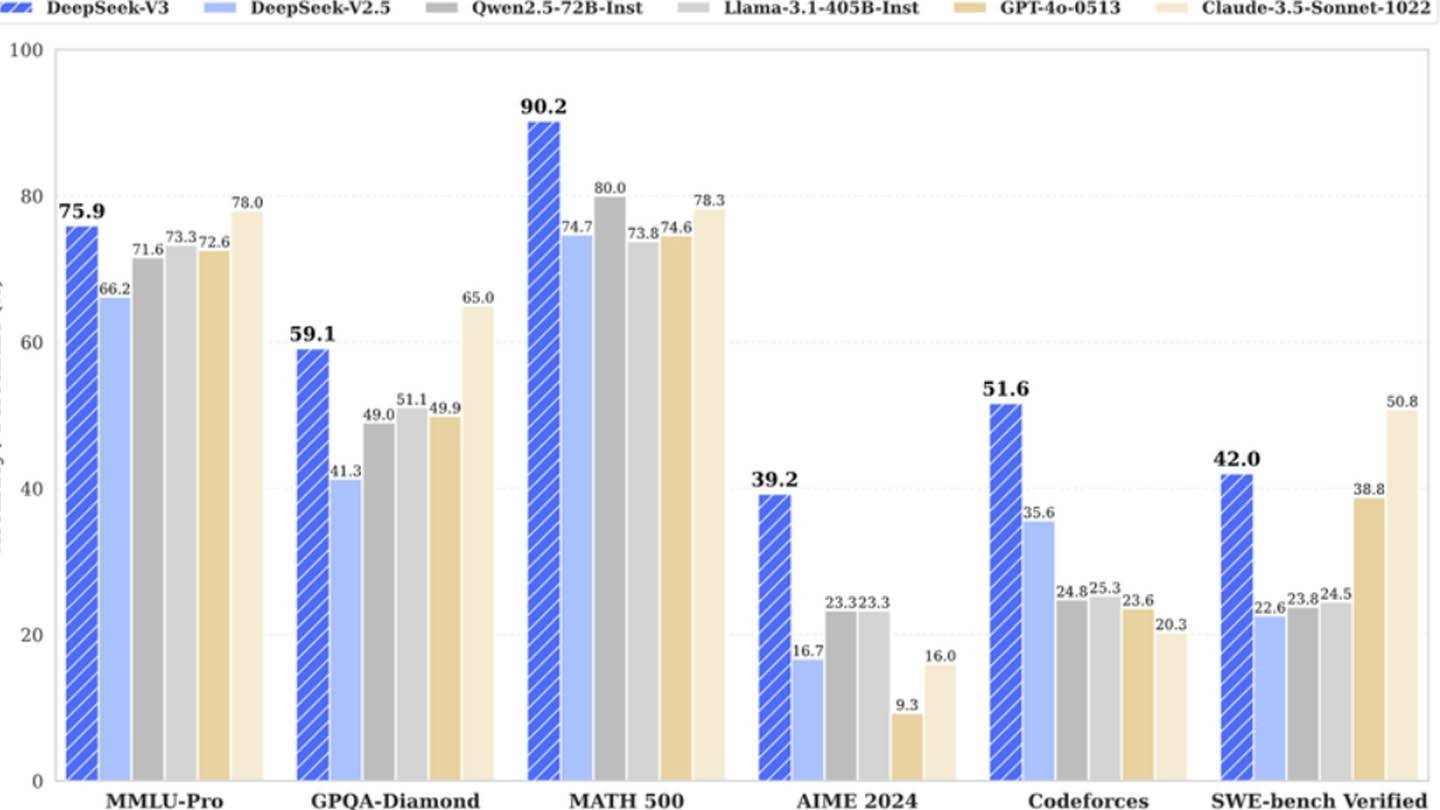

DeepSeek的廉价AI模型令人惊讶地挑战了行业规范。该公司声称使用2048 GPU培训了其功能强大的DeepSeek V3神经网络,仅需600万美元,大大削弱了竞争对手。但是,该数字仅反映了培训前的GPU成本,省略了大量研究,改进,数据处理和基础设施费用。

图像:ensigame.com

图像:ensigame.com

DeepSeek V3的创新架构是其效率的关键。它利用:

- 多语预测(MTP):同时预测多个单词,以提高准确性和速度。

- 专家(MOE)的混合物:使用256个神经网络,每个令牌激活8个,加速培训并提高性能。

- 多头潜在注意力(MLA):反复提取关键细节以最大程度地减少信息丢失并捕获至关重要的细微差别。

图像:ensigame.com

图像:ensigame.com

尽管培训成本较低,但半分析揭示了DeepSeek的大量基础设施:大约50,000个NVIDIA HOPPER GPU(包括10,000 H800、10,000 H100和额外的H20 GPU)在多个数据中心扩展。这代表了一项总服务器投资约16亿美元,运营成本估计为9.44亿美元。这与公开的600万美元的预培训成本形成鲜明对比。

图像:ensigame.com

图像:ensigame.com

中国对冲基金High-Flyer的子公司DeepSeek拥有其数据中心,提供控制和更快的创新实施。它的自资助性质增强了敏捷性。该公司吸引了中国顶级人才,一些研究人员每年收入超过130万美元。尽管DeepSeek的成本效益是相对的,但其成功源于大量投资,技术进步和高技能的团队。

图像:ensigame.com

图像:ensigame.com

该公司对AI开发的总体投资超过5亿美元。与更大的官僚组织相比,其简化的结构有助于有效的创新。尽管“革命性预算”的叙述可以说是夸大的,但DeepSeek的模型培训成本(R1的500万美元)仍然大大降低了诸如Chatgpt4o(1亿美元)的竞争对手。最终,DeepSeek展示了一家资金充足,独立的AI公司与已建立的巨头有效竞争的潜力。